Blackbox KI

Was drin ist, entscheidet der Markt

von Victor Chaix, Auguste Lehuger und Zako Sapey-Triomphe

Im November 2023 kam es in der Chefetage von OpenAI, das durch seinen Chatbot ChatGPT berühmt wurde, zu einem Konflikt der besonderen Art. Auf Initiative von Firmenmitbegründer und Verwaltungsratsmitglied Ilya Sutskever wurde CEO Sam Altman entlassen. Am Ende kehrte Altman, ebenfalls Mitgründer von OpenAI, auf seinen Posten zurück, aber die Episode offenbarte den internen Grabenkampf zwischen Vertretern zweier Ideologien, die auf den ersten Blick gegensätzlich wirken, aber im Grunde nicht allzu weit auseinanderliegen: effektiver Altruismus und effektiver Akzelerationismus. Die Altruisten hatten – erfolglos – versucht, die Gurus des Akzelerationismus auszubooten, weil sie fürchteten, diese würden das Ende der Menschheit heraufbeschwören.

Der effektive Altruismus trat in den 2000er Jahren in den USA auf den Plan. Er zielt darauf ab, alle verfügbaren Ressourcen so einzusetzen, dass das Wohl der Allgemeinheit maximiert wird. Seine Fürsprecher sind von ihrer intellektuellen, finanziellen und technischen Überlegenheit so überzeugt, dass sie sich berufen fühlen, die wichtigsten Probleme der Menschheit nach Dringlichkeit zu hierarchisieren und zu lösen – allen voran die Gefahren durch Pandemien, einen Atomkrieg und die aufstrebende „Artificial General Intelligence“ (AGI), manchmal auch als „Singularität“ bezeichnet.

Die AGI ist eine künstliche Intelligenz, die auf der Grundlage gewaltiger Datenmengen ein eigenes Bewusstsein entwickelt. Je nach Sichtweise wird sie die Menschheit entweder in ein Zeitalter des universellen Wohlstands oder in die Vernichtung führen. Die Definition dieser AGI ist allerdings so vage, dass einige sagen, es gäbe sie bereits, während andere erst in 50 Jahren mit ihrer Verwirklichung rechnen.

Der effektive Akzelerationismus ist radikaler als der effektive Altruismus. Seine Verfechter plädieren dafür, der technologischen Entwicklung keine Fesseln anzulegen und die übermenschliche AGI so schnell wie möglich zu realisieren, damit sie die Menschheit auf eine höhere Entwicklungsstufe hebt und sie vor den aktuell drohenden Gefahren rettet. Damit das gelingt, fordern sie, dass alle regulatorischen und ethischen Bremsklötze entfernt und Urheberrechts- und Datenschutzfragen ausgeblendet werden. Es komme nur auf eines an: Schnelligkeit.

Dieser ungenierte Techno-Liberalismus hält es für richtig, Systeme auf den Markt zu bringen, von denen niemand genau weiß, wie sie funktionieren und welche Folgen sie haben könnten. Ein prominentes Beispiel dafür ist die Freigabe von ChatGPT durch OpenAI. Hier zeichnet sich das Gesellschaftsmodell der Digitalindustrie und ihrer Verbündeten ab – ein Gesellschaftsmodell, das ausschließlich einem funktionalen Imperativ folgt.

Nach einer Formulierung des Philosophen Marcello Vitali-Rosati handelt es sich dabei um „die kapitalistische Version des rationalen Imperativs, bei der die Rationalität zurücksteht hinter

der Notwendigkeit, Reichtum zu produzieren und Güter zu akkumulieren.“1

Auf diese Weise soll die Ersetzung des Menschen durch Maschinen als Horizont des gesellschaftlichen, wirtschaftlichen und technologischen Wandels unserer Zeit in der kollektiven Vorstellungswelt verankert werden.

Dass es so kommen wird, ist zwar wahrscheinlich, aber nicht unausweichlich. Staatliche Eingriffe in der Industriepolitik – noch vor Kurzem totgesagt – erleben seit einigen Jahren beidseits des Atlantiks ein Comeback. Die westlichen Eliten halten sie inzwischen für unverzichtbar im Konkurrenzkampf mit Asien.

Auch die ökologische Planung erlebte zuletzt eine neue Dynamik. Von den US-Demokraten und ihrem „New Green Deal“ bis zur EU-Kommissionspräsidentin Ursula von der Leyen und ihrem „European Green Deal“ – viele wollen die Möglichkeiten der Staatsmacht und der neuen Technologien mobilisieren, um den Übergang zu einer umweltfreundlicheren – aber weiterhin liberalen – Wirtschaft zu organisieren.

Die Linke hingegen betont, die Produktion müsse auf die gesellschaftlichen Bedürfnisse und ökologischen Sachzwänge ausgerichtet werden. Und manche linke Stimmen sind dafür, die Möglichkeiten der industriellen Koordinierung zu nutzen, und bauen auf Systeme des kollektiven Entscheidens, die Informations- und Kommunikationstechnologien für sich nutzen.2

„Können wir uns Informations- und Kommunikationstechnologien vorstellen, die uns weder ausnutzen noch betrügen und auch nicht ersetzen?“, fragt der britische Schriftsteller James Bridle. „Ja, das können wir – sobald wir aus den kommerziellen Machtstrukturen aussteigen, die zur bestimmenden Größe der aktuellen KI-Welle geworden sind.“3

Beide Enden des politischen Spektrums setzen also ihre Hoffnung auf technischen Fortschritt, der nur noch auf ihre jeweiligen ideologischen Präferenzen abgestimmt werden müsse. Die künstliche Intelligenz (KI) ist aber von der Entwicklung bis zur Realisierung in keinem Punkt neutral. Wer entwirren will, wie sich beim Bau einer KI Technisches und Politisches ineinander verstricken, muss die Blackbox KI öffnen und verstehen, was sie ausmacht und wie sie lernt. Dieser entscheidende Schritt wird in der öffentlichen Debatte oft übersprungen, aber er ist die Voraussetzung dafür, sowohl den Fantasien eines magischen Solutionismus als auch der Angst vor der Menschwerdung der KI den Boden zu entziehen.

Die künstliche Intelligenz ist an der Schnittstelle von Mathematik und Informatik angesiedelt und arbeitet praktisch wie ein Input/Output-System – wie eine mathematische Funktion, die auf der Basis einer Datenbank lernt, auf präzise gestellte Fragen korrekte Antworten zu liefern, um eine festgelegte Aufgabe bestmöglich zu erfüllen.

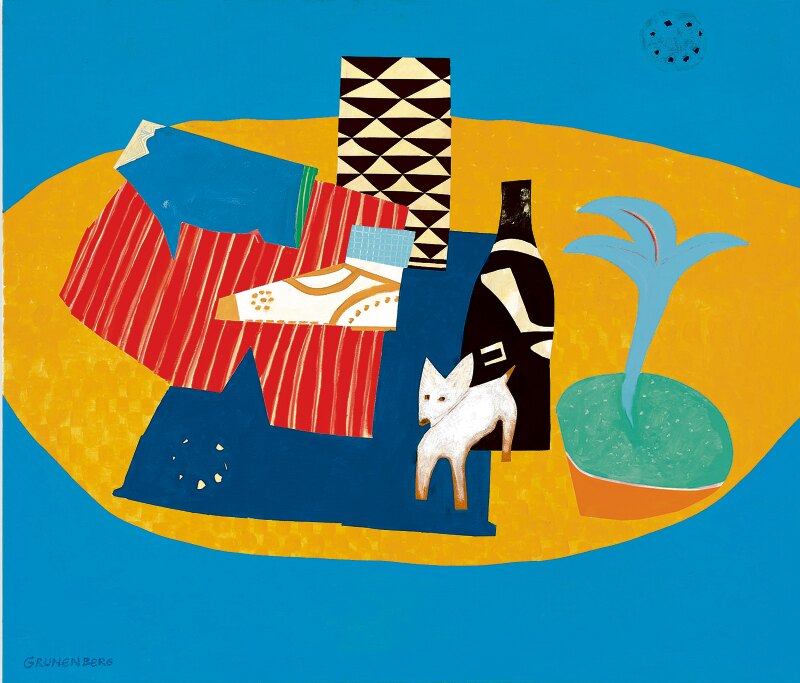

Wenn sie zum Beispiel Tiere erkennen soll, muss sie jedem Bild die richtige Bezeichnung zuordnen („Hund“ oder „Pelikan“). Trainiert wird das Programm mithilfe einer Datenbank voller Bilder, die mit Bezeichnungen verknüpft sind. Ziel ist das Minimieren der Zuordnungsfehler. Nach jedem Versuch justiert ein Protokoll die Parameter nach. Sobald die Fehlerwahrscheinlichkeit auf ein akzeptables Niveau gesunken ist, bringt das Unternehmen das System auf den Markt.

So weit die Theorie. In der Praxis verbergen sich hinter dem vermeintlich klinisch-neutralen Prozess hochpolitische Entscheidungen – zum Beispiel, welche Daten als Basis für den Lernprozess herangezogen werden. Oft stecken in diesen Trainingsdaten diskriminierende Vorurteile, die die Entwickler unbewusst übernehmen. Die KI „Pulse“, die 2020 von Studierenden der Duke University in den USA entwickelt wurde und dazu dient, pixelige Bilder in scharfe Fotos zu verwandeln, hatte die Tendenz, Personen mit nichtweißer Hautfarbe aufzuhellen, sodass sie am Ende sogar einen „weißen Obama“ generierte.4

Das war natürlich keine Absicht. Das Pulse-Team hatte für die Konstruktion seines Algorithmus ein anderes KI-System verwendet – das von Nvidia entwickelte StyleGAN. StyleGAN war darauf programmiert, Bilder realistisch wirkender menschlicher Gesichter zu generieren, lieferte aber aufgrund des Trainings, das es selbst durchlaufen hatte, überproportional viele Bilder von weißen Männern.

Der Algorithmus von Pulse enthielt zwar selbst keine inhärenten Vorurteile, übernahm aber indirekt den Bias von StyleGAN: Als das Programm aus einem Porträt Barack Obamas in schlechter Bildqualität ein Bild mit höherer Auflösung machen sollte, kam ein weißes Gesicht heraus. Auf diese Weise schleichen sich implizite Vorannahmen und Stereotype unbemerkt in die Technologie ein und werden zur Normalität erhoben, denn Maschinen gelten schließlich als objektiv und ideologiefrei.

Wenn der Algorithmus Obama weiß macht

Abgesehen davon, dass die Trainingsdaten nicht immer repräsentativ sind, ist auch die Formalisierung des angestrebten Ergebnisses oftmals problematisch. Hier geht es darum, die Anforderungen der gestellten intellektuellen Aufgabe mit mathematischen Formeln synthetisch nachzubilden. Empfehlungsalgorithmen etwa sollen in der Theorie für den Nutzer besonders relevante Inhalte auswählen, aber wenn man die mathematische Umsetzung dieser Aufgabe genauer unter die Lupe nimmt, kommt eine ganz andere Zielsetzung zum Vorschein: Der Algorithmus soll den Nutzer möglichst lange am Bildschirm halten, indem er ihm effektheischende Zusatzinhalte offeriert und auf diese Weise seine Aufmerksamkeit in Beschlag nimmt.

In einer Welt, in der unser digitales Dasein von Automaten orchestriert wird, stellt sich eine grundsätzliche Frage, die allerdings selten formuliert wird: Sollten private Unternehmen allein darüber entscheiden, welche Ziele eine KI verfolgt? Die nationale und internationale Politik ist vor allem damit beschäftigt, allzu spektakuläre Auswüchse zu regulieren oder Inhalte zu zensieren, und kümmert sich wenig um diese technisch-politischen Grundsatzentscheidungen. Dabei wären ein gemeinschaftlicher Diskurs und eine engmaschigere gesellschaftliche Kontrolle – wie sie immer mehr Akteure in dem Sektor fordern5 – durchaus angebracht.

Massenhaftes Datensammeln ist kein Ersatz für demokratisches Nachdenken und kritischen Dialog. Doch alles scheint darauf ausgelegt, genau das zu verhindern – angefangen von der Organisation der KI-Forschung bis hin zum Begriff „künstliche Intelligenz“ selbst. Dieser Begriff ist für die breite Öffentlichkeit auf Anhieb verständlich, er suggeriert aber tatsächlich genau das Gegenteil dessen, was mit ihm bezeichnet wird.

Genau genommen müssten wir bei KIs von „Rechenautomaten“6 sprechen. Das ist weit weniger schmeichelhaft, aber zutreffender, denn diese Modelle erreichen ihre Ziele dadurch, dass sie die beste Möglichkeit errechnen, vergangene Resultate zu replizieren. Der Begriff „Intelligenz“ dagegen suggeriert eine Ent-Automatisierung, wie sie für jeden kreativen Prozess wesentlich ist: ein Bemühen, über vorgefertigte und stereotype Muster hinauszudenken.

Wenn digitale Technologien in den Dienst kollektiver Entscheidungen – einschließlich unserer Erfindungs-, Vorstellungs- und Interpretationsfähigkeiten – gestellt werden sollen, braucht es eine andere Vision von „Intelligenz“ als die der Unternehmer im Silicon Valley und der Transhumanisten. Der Verband „Ars Industrialis“ formuliert es so: „Dumm oder intelligent ist nicht so sehr dieses oder jenes Individuum oder dieses oder jenes Milieu, sondern eher die Beziehung, die sie miteinander verbindet.“7

Von dieser Idee waren die Arbeiten der utopistisch gesonnenen Informatiker der 1960er und 1970er Jahre durchdrungen.8 Es geht nicht darum, sich zwischen künstlichem Umfeld und menschlichem Geist zu entscheiden, sondern um eine „neue Allianz mit der Maschine“, zu der 1992 der Philosoph Félix Guattari aufrief.9

Einstweilen scheint diese Aussicht in weiter Ferne, weil selbst die besten Wissenschaftler:innen kaum verstehen, was in der Blackbox der Algorithmen vor sich geht. Wer heute ein KI-Modell auf den Markt bringt, muss nicht mehr „erklären“ können, wie dieses KI-Modell funktioniert – muss also den vom System generierten Output nicht übersetzen können in eine „Abfolge von Schritten, die so miteinander verbunden sind, dass ein menschliches Wesen sie in eine sinnvolle Kausalbeziehung bringen kann.“10

Dieser Prozess galt einst als elementares Prinzip der geistigen Hygiene, ist heute aber nur noch ein optionales Sahnehäubchen. Die Forschung ist so stark technisch dominiert, dass selbst die Forscher:innen erst mehrere Jahre nach der Markteinführung begreifen, was in der Blackbox KI eigentlich vor sich geht.

Wie soll der Gesetzgeber – zumal in so sensiblen Bereichen wie dem Gesundheits- oder Bildungswesen – Maßstäbe zur Beurteilung von Systemen festlegen, von denen niemand weiß, wie sie arbeiten? Das MIT Media Lab hat für unsere Interaktion mit diesen Blackboxes den Begriff „AI Alchemy“11 geprägt. Diese Metapher spiegelt nicht nur ein allgemeines Unbehagen, sondern liefert einen methodischen Ansatzpunkt, um sich auf die Undurchdringlichkeit von KI-Modellen einen Reim zu machen.

Einstweilen bleibt die künstliche Intelligenz ein sonderbares Konglomerat aus wissenschaftlicher Forschungsdisziplin, Technologie und Wachstumsmarkt, wobei in allen drei Bereichen eine Handvoll Akteure den Ton angeben, die es in puncto Finanzkraft und industriepolitischer Expertise mit so manchem G20-Staat aufnehmen können.

Die Verkürzung des Innovationsprozesses – von der Grundlagenforschung bis zur Markteinführung – auf wenige Jahre oder sogar Monate ist unverkennbar ein Resultat des Akzelerationismus. Verstärkt wird diese Dynamik durch die kurzfristigen Rentabilitätserfordernisse der Märkte und die schwachen regulatorischen Beschränkungen.

Diese Imperative sind zur Richtschnur für große Teile der Wissenschaftsproduktion geworden. Das zeigt sich unter anderem an dem Einfluss, den sie auf die wichtigsten einschlägigen Konferenzen wie die Conference on Neural Information Processing Systems (NeurIPS) oder die International Conference on Machine Learning (ICML) ausüben. Die KI-Agenda wird vor allem durch private Unternehmen und ihre Forschungsabteilungen mit ihren gigantischen Ressourcen vorgegeben, denn Recheninfrastruktur ist teuer, und die besten Köpfe arbeiten dort, wo am meisten gezahlt wird.

Wie in vielen anderen Bereichen auch kann der Weg zu Guattaris „neuer Allianz“ nur über eine Trennung von Staat und Markt führen.

1 Marcello Vitali-Rosati, „Éloge du bug. Être libre à l’époque du numérique“, Paris (Zones) 2024.

3 James Bridle, „The stupidity of AI“, The Guardian, 16. März 2023.

5 Joana Varon u. a., „Fostering a Federated AI Commons ecosystem“, T20 Policy Briefing, Juni 2024.

8 Siehe Evgeny Morozov, „Eine andere KI ist möglich“, LMd, August 2024.

9 Siehe Félix Guattari, „Pour une refondation des pratiques sociales“, LMd (Paris), Oktober 1992.

Aus dem Französischen von Andreas Bredenfeld

Victor Chaix ist Doktorand in Digital Humanities, Auguste Lehuger ist KI-Entwicklungsingenieur, Zako Sapey-Triomphe ist Ingenieur. Der Text ist eine Kurzfassung eines Beitrags, der im Oktober auf der Website der Denkfabrik X-Alternative veröffentlicht wurde.